颠覆想象的AI绘画:Dall-E 2使用指南

围绕OpenAI推出的第二代DALL-E 2系统的讨论一直处于两极分化的状态,甚至在其推出了几个月后依旧如此。

有用户认为这是一项可以重新定义艺术的突破性创新,而批评者则将其视为人工智能图像生成器给创意产业带来厄运的开始。

然而毫无疑问的是,DALL-E 2为我们创造和消费艺术开辟了新的可能性和挑战。本文详细介绍了AI图像生成器DALL-E 2的用法和缺点。

什么是DALL-E 2?

DALL-E 2是一款人工智能图像生成器,它可以根据自然语言的文本描述创建图像和艺术形式。换句话说,它是一个根据文本生成图像的人工智能系统。

2021年1月,OpenAI推出了DALL-E模型,DALL-E 2是其升级版。“DALL-E”这个名字源于西班牙著名艺术家Salvador Dalí和广受欢迎的皮克斯动画机器人“Wall-E”的组合。

2022年7月,DALL-E 2进入测试阶段,可供白名单中的用户使用。同年9月28日,OpenAI取消了白名单的要求,推出了任何人都可以访问并且使用的开放测试版。

与最初的DALL-E一样,DALL-E 2也是一种语言生成模型,它使用文本提示来创建原始图像。

尽管和之前DALL-E具有的120亿个参数的模型不同,DALL-E仅仅具有大约35亿个参数,但DALL-E 2生成的图像分辨率是DALL-E的四倍,这是一次令人印象深刻的升级。同时,DALL-E 2在真实感和字幕匹配方面似乎也做得更好。

如何使用DALL-E 2?

听起来,DALL-E 2很有未来感,可能会让新用户望而生畏,但它使用起来非常简单。我们不进行详细介绍,仅通过迷你教程为大家提供快速概览。

首先,登陆DALL-E 2的官网并创建一个帐户,如果您此前已经拥有OpenAI的帐户,登陆即可。需要注意的是,系统会要求您提供电子邮件和电话号码以进行验证。

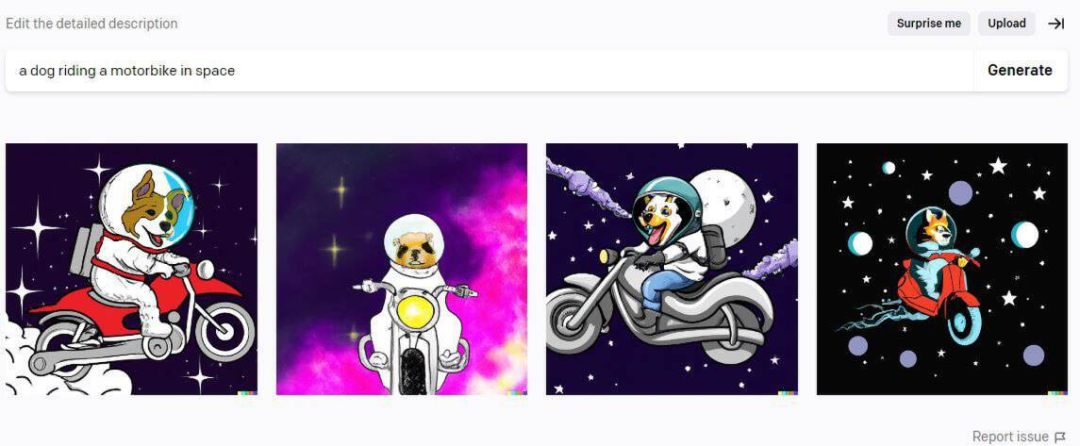

一旦帐户准备就绪,我们就可以开始生成图像。用户最多提供400个字符的描述性文本,AI艺术生成器将对其进行处理。根据测试,我们可以从文本提示中得到许多原创且有趣的结果。

比如,我们输入“狼群在满月时嚎叫”就收到了如下的结果。

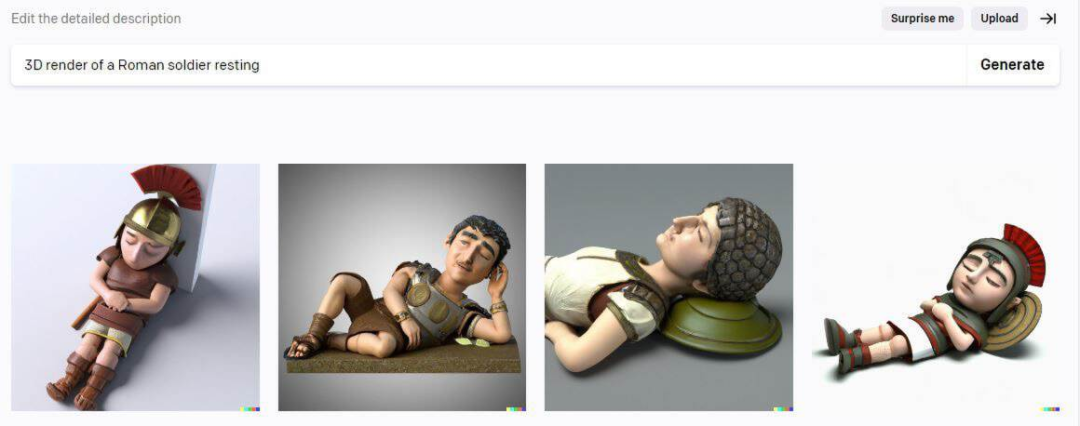

输入“一个3D渲染的罗马士兵正在休息”则获得了以下的图像。

DALL-E 2的工作原理是什么?

DALL-E 2为AI图像生成器的质量提供了新的基准。它与之前的同类产品相比,能够更好地理解文本描述。

其卓越的自然语言理解能力可以更严格地控制图像的风格、主题、角度、背景、位置和概念,并获得更高质量的图像和令人印象深刻的艺术形式。

那么让我们来看看DALL-E 2的工作原理。

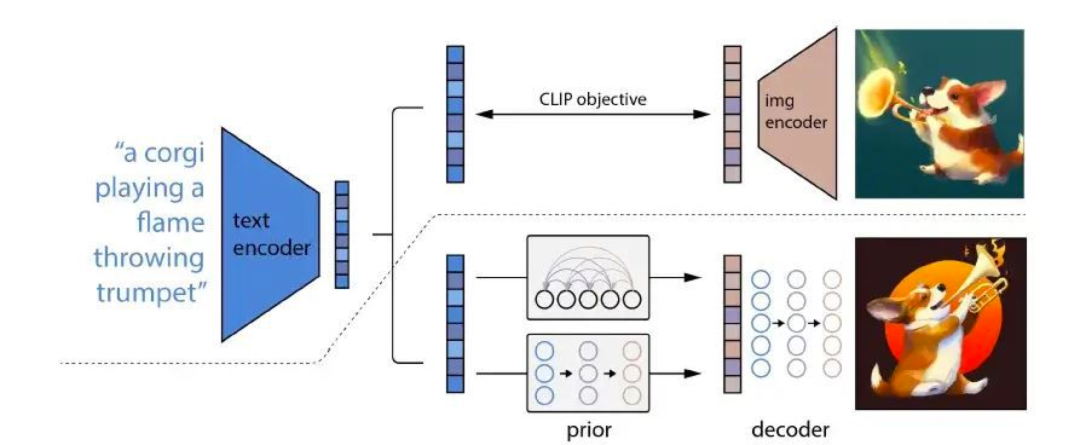

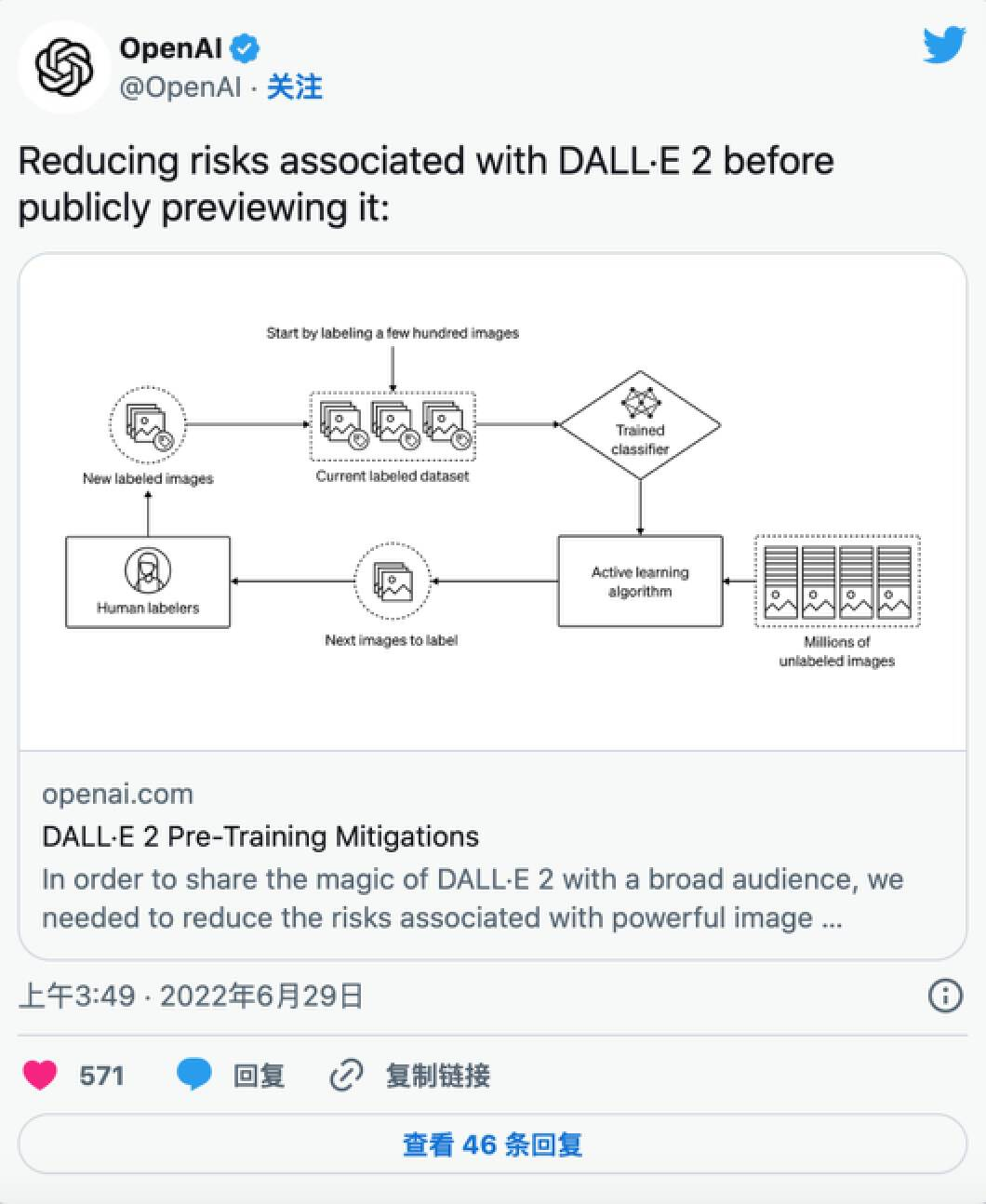

要了解AI图像生成器的工作原理,我们首先需要了解CLIP、先验模型和解码器扩散模型(unCLIP)。

什么是CLIP?CLIP指的是对比语言图像预训练,是DALL-E 2架构中最关键的模块。

该训练基于用户可以用自然语言教计算机不同图像之间如何相互关联,并由文本和图像编码器这两个神经网络组成。

文本和图像编码器都接受了大量不同的图像文本对集合的训练。该模型分析这些图像-标题对以创建称为文本/图像嵌入的矢量表示。换句话说,CLIP充当文本(输入)和图像(输出)之间的桥梁。

先验模型采用标题/CLIP文本嵌入,并以此为基础生成CLIP图像嵌入。

unCLIP则是使用CLIP图像嵌入生成图的原始CLIP模型的逆模型。DALL-E 2通过先验模型和unCLIP模型来创建输出。

下图大致概述了其基本过程。

如图所示,unCLIP模型创建了图像的“心理”表示。基于此,创建了原始图像。

这些“心理再现”保留了语义一致的核心特征和特点,例如“动物、物体、颜色、风格和背景等关键要素”。然而,因为扩散学习是变化的,每一次输出的图像也会有所不同。

请注意,上文只是DALL-E 2工作原理的简要表述,实现的技术细节和数学更加复杂,我们就不在这里赘述。如果您对DALL-E 2的技术规格感兴趣,可以参看OpenAI在今年早些时候发表的论文《Hierarchical Text-Conditional Image Generation with CLIP Latents》。

使用DALL-E 2可以做什么?

只要用户给出精确和具有描述性的文本提示,就可以通过AI艺术生成器得到多个高质量的图像,甚至在几秒钟的时间里实现画家或数字艺术家需要数小时甚至数天才能达到的质量水平。

用户可以免费查看所有这些视觉创意,无需支付场地费,也无需向创意人员和模特支付工资。

然而这也对我们的内容创作经济带来了一定的影响。

DALL-E 2使用自己对主题、风格、调色板和所需概念意义的“理解”,生成相应的图像。

每个图像最多可以产生四个变体。每一个都与原作的外观、感觉和意义相呼应,但又具有自己独特的风格。

您也可以在DALL-E 2中编辑图像,无需任何照片编辑经验。与Adobe Photoshop不同,使用DALL-E进行编辑非常简单。

例如,用户想要在火星上行走的宇航员的肖像中添加一只狗,只需要输入“在宇航员身后放一只狗”。同样,用户还可以要求程序通过放大和缩小来更改图像的视图框架,直到获得所需的结果。而就DALL-E 2的功能而言,这些只是冰山一角。

同时,根据设计,该系统无法生成涉及色情、血腥或政治元素的内容。也就是说,该程序有其合理的局限性和缺点。

DALL-E 2的局限性

DALL-E 2的输出质量很大一部分取决于用户提供的文本提示的质量,文本越具体,获得所需输出的机会就越高。然而,该系统有一些内在的局限性。

例如,当前它还不具有很精确组合性,尽管似乎会随着时间的推移而改善。这意味着DALL-E 2通常无法有意义地合并多个对象或对象属性,例如形状、方向和颜色。

同时在一些意料之外的情况下,有一些相对简单的文本,程序也可能无法充分执行。

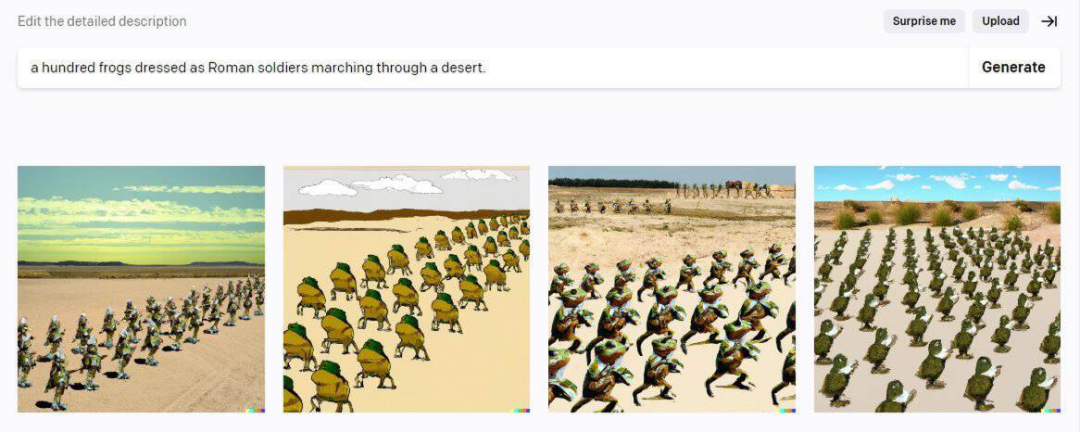

例如,我们输入文本“一百只打扮成罗马士兵的青蛙在沙漠中行进”。即使我们尝试了多种提示变体,结果也不尽如人意。

另一个例子是当我们尝试相当简单的提示时,如“霸王龙骑着独轮车在艾菲尔塔前”。不知道为什么,程序拒绝画独轮车,取而代之的是自行车。而当我们从提示中删除“Eifel Tower”,产生预期图像则没有任何阻碍。

这些只是DALL-E 2局限性的几个例子。更令人担忧的问题本质上很复杂,可能会对公司及其用户造成严重不良影响。

OpenAI限定DALL-E 2不创建公众人物和名人的图像。事实上,它完全拒绝生成包含真实面孔或真人的图像,这是朝着防止滥用该程序迈出的重要一步。

随着DALL-E 2越来越受欢迎,版权侵权也可能成为一个大问题。OpenAI坚持认为,用户“获得了将他们使用DALL-E创建的图像商业化的全部权利,包括转载、销售和商品化的权利。”

然而,人工智能艺术生成器依赖于分析、学习人类艺术家的作品来创造艺术。因此,不能排除潜在的侵犯知识产权法的可能性,无论是否有意。

总结

DALL-E 2完美吗?作为一项正在完善的项目,答案是否定的。

但是,正如机器学习的本质一样,随着时间的推移,该程序正变得越来越聪明,也越来越有能力。从纯技术的角度来看,DALL-E 2是AI技术演进的一大进步。

人们普遍认为人工智能系统在创意领域实际上无法超越人类,至少不会很快。但是DALL-E 2已经使这个论点受到了冲击。

然而尽管OpenAI已经采取了一系列措施来预测和防止DALL-E 2的潜在滥用,但这并非万无一失。在没有任何道德界限的情况下可以使用的AI系统将在多久后出现?需要我们保持警惕。

无论如何,我们都需要密切关注这个新兴行业。因为AI艺术生成器及其背后的技术只会在未来的岁月里变得更加普遍。

原文由Shilpa Lama撰写,中文内容由元宇宙之心(MetaverseHub)团队编译,如需转载请联系我们。

原文标题 : 颠覆想象的AI绘画:Dall-E 2使用指南

最新活动更多

-

3月27日立即报名>> 【工程师系列】汽车电子技术在线大会

-

即日-4.22立即报名>> 【在线会议】汽车腐蚀及防护的多物理场仿真

-

4月23日立即报名>> 【在线会议】研华嵌入式核心优势,以Edge AI驱动机器视觉升级

-

4月25日立即报名>> 【线下论坛】新唐科技2025新品发布会

-

在线会议观看回放>>> AI加速卡中村田的技术创新与趋势探讨

-

即日-5.15立即报名>>> 【在线会议】安森美Hyperlux™ ID系列引领iToF技术革新

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论