谷歌AI奠基论文被指“翻车”!开山鼻祖给AI带来了什么?

“武功再高,也怕菜刀”。就算是开山鼻祖,也有翻车的一天。

现阶段类GPT(Generative Pre-trained Transformer)的语言大模型像雨后春笋一样,不断涌现。虽说这股浪潮是由ChatGPT引爆,但在这所有AI大模型的背后其实还有一个更关键的技术概念——Transformer架构。

然而就在今天,有人扒出来提出Transformer架构的论文《Attention Is All Your Need》翻车了!论文里面的图片和代码是不一致的。

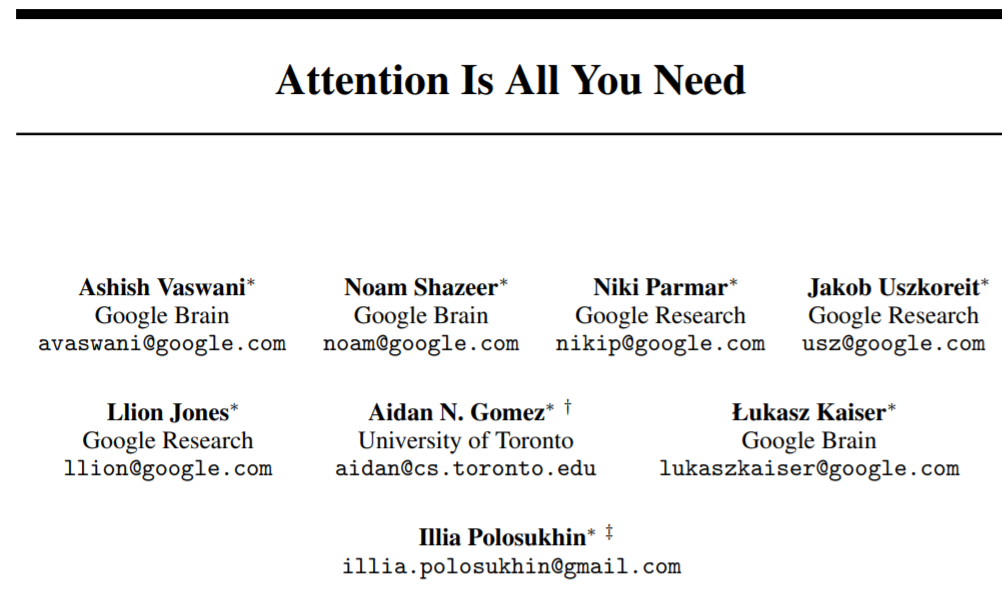

2017年,谷歌大脑团队发表了名为《Attention Is All Your Need》的论文,在论文里他们开创性的提出了Transformer架构。此后它成了NLP(自然语言处理)领域最受欢迎的模型之一,也正是有了这个架构,我们才能见到ChatGPT这样的AI大模型。

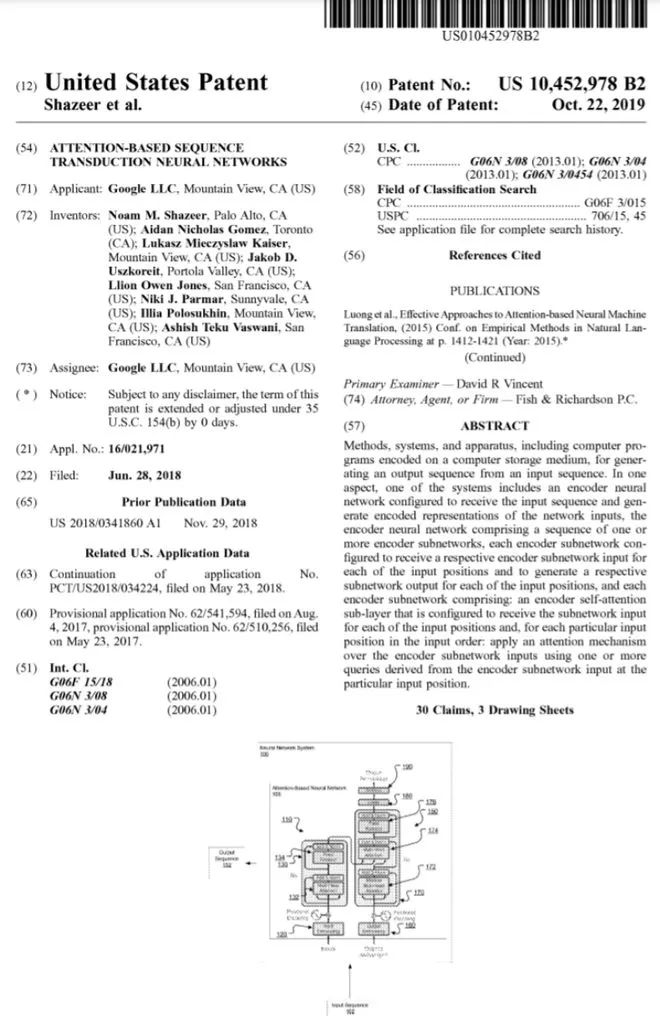

所以业内都把Transformer架构奉为AI领域的奠基石,这篇论文也成为了AI探索和研究的“金科玉律”。2019年,谷歌特地为该架构申请了专利。

据资料显示,自2017年发表以来,《Attention Is All Your Need》这篇论文已经被引用了7万多次。现在被曝出论文可能出错了,这不得不让整个AI圈震惊。

“开山鼻祖”竟然翻车了?

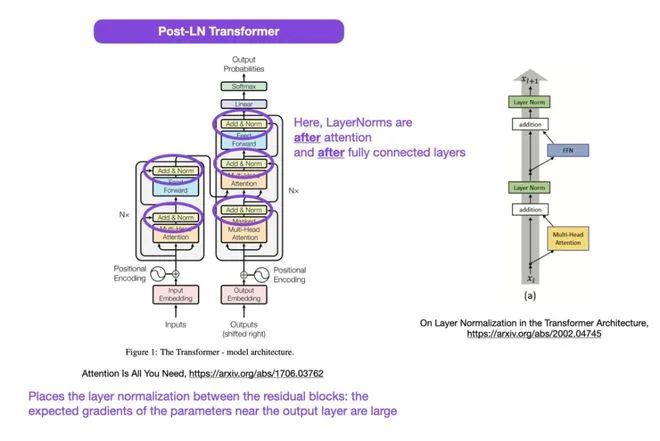

发现错误的是一位知名机器学习与 AI 研究者、初创公司 Lightning AI 的首席 AI 教育家 Sebastian Raschka。他指出,原始 Transformer 论文中的架构图有误,这跟代码不一致。

他结合了另外两篇同样涉及Transformer架构的论文,来佐证《Attention Is All Your Need》里的出现的结构图是不对的,可能会导致表示崩溃。这对于一篇指导了几乎所有AI开发的论文来说,是不能接受的。

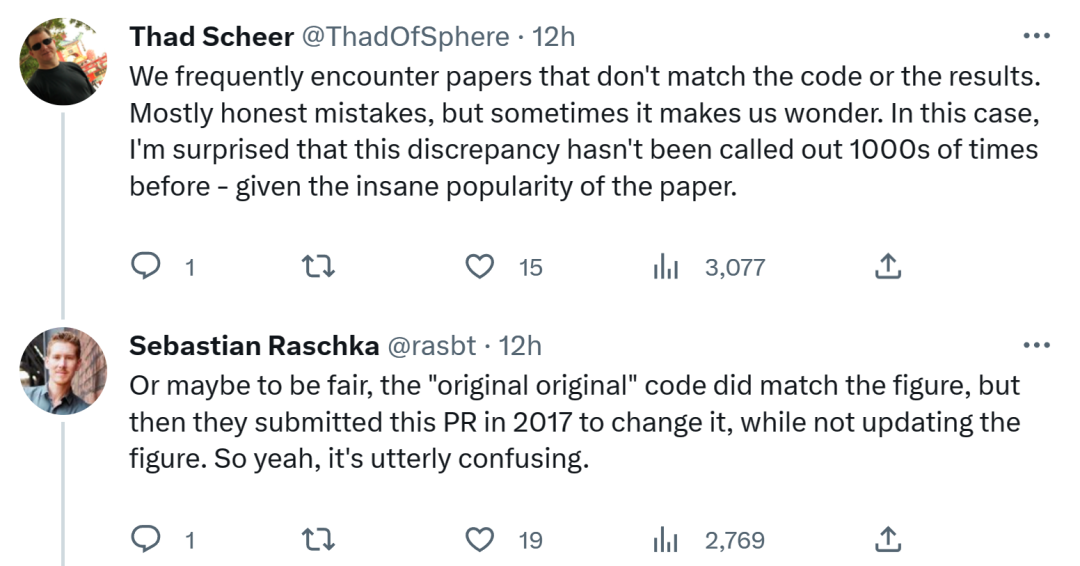

针对他提出的错误,有网友认为经常会遇到与代码或结果不一致的论文,大多数是无心之过;但有时令人感到奇怪。考虑到 Transformer 论文的流行程度,这个不一致问题早就应该被提及 1000 次。

对此 Sebastian表示,公平地讲,“最最原始”的代码确实与架构图一致,但 2017 年对提交的代码版本进行了修改,同时没有更新架构图。所以,这实在令人困惑。

“奠基石”也并非一劳永逸

Transformer架构“教出”了一批优秀的学生,让AI领域获得前所未有的关注,也昭示了AI技术的发展方向。

但业界对技术的追求,一直都不满足现状。

经过大量实践,开发者发现凡是采用Transformer架构的类GPT大模型,都有共同的缺陷,就是太容易健忘,一旦输入序列的token超过上下文窗口阈值,后续输出的内容和前文逻辑就对不上了。

ChatGPT只能支持4000个token(约3000个词)的输入,目前地表最强的GPT-4也只支持最大32000token窗口,如果继续加大输入序列长度,计算复杂度也会成二次方增长。

前段时间,伦敦数学科学研究所的研究人员发布了一篇技术报告,使用循环记忆Transformer(RMT)将BERT的有效上下文长度提升到前所未有的200万tokens。该方法可以存储和处理局部和全局信息,并通过使用循环让信息在输入序列的各segment之间流动。

百度在推出文心一言大模型之后,不停地对其进行训练,并加快了迭代速度。

在5月9日举行的百度文心一言技术交流会上,百度集团副总裁侯震宇表示,下一阶段人工智能大模型的创新还要从前沿理论研究方面寻找突破口,就比如说探寻突破Transformer框架的方式。

开山论文的缔造者,已各奔东西

最近,OpenAI 联合创始人 Ilya Stutskever 在谈到 Transformer 时表示,当 Transformer 刚发布之初,实际上是论文放出来的第二天,他们就迫不及待的将以前的研究切换到 Transformer ,后续才有了 GPT。

而作为Transformer的缔造者——《Attention Is All Your Need》论文作者们,大多都选择了自己的道路。

Ashish Vaswani、Niki Parmar等人共同创立了Adept,根据披露的消息这是一家跟OpenAI竞争的大模型公司。目前已经获得了4.15亿美元的融资,且估值超过10亿美元。

Noam Shazee在 2000 年底加入谷歌,直到 2021 年最终离职。2021年,他和他的朋友Daniel De Freitas一起创立了CharacterAI。这是一家虚拟人聊天AI公司,能生成各种不同人格的虚拟人支持陪聊。目前已经获得了近2亿美元的融资。

2021 年,Jakob Uszkoreit 和 Rhiju Das 共同创立了 Inceptive,致力于通过高度可扩展的实验和深度学习的奇异结合来实现下一代 RNA 分子的设计,已经获得了2000万美元的融资。

Llion Jones是8人中目前唯一还在谷歌工作的。他声称对论文作出了最有意义的贡献:写下了Attention is all you need这个响亮的标题。

Aidan Gomez于2019年9月离开Google。2021 年 5 月,他官宣成立新公司——自然语言处理平台 Cohere,基于自己训练的大型 NLP 模型为外界提供 API 服务。目前已经获得了近4亿美元的融资,员工人数超过180名。

Lukasz Kaiser也是知名的机器学习系统Tensor Flow的共同创造者之一,2021 年 6 月,Lukasz Kaiser 从谷歌跳槽到了 OpenAI。

Illia Polosukhin现在是 NEAR.AI 的联合创始人及 CTO。这是一家区块链底层技术公司,目前估值约为20亿美元。

最新活动更多

-

3月27日立即报名>> 【工程师系列】汽车电子技术在线大会

-

4月1日立即下载>> 【村田汽车】汽车E/E架构革新中,新智能座舱挑战的解决方案

-

即日-4.22立即报名>> 【在线会议】汽车腐蚀及防护的多物理场仿真

-

4月23日立即报名>> 【在线会议】研华嵌入式核心优势,以Edge AI驱动机器视觉升级

-

4月25日立即报名>> 【线下论坛】新唐科技2025新品发布会

-

即日-5.15立即报名>>> 【在线会议】安森美Hyperlux™ ID系列引领iToF技术革新

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论