AMD英伟达“战火”升级!发布世界最强芯片瞄准英伟达AI“王座”

随着AI大模型的兴起和各类应用的层出不穷,以GPU为代表的算力芯片供不应求、交期拉长,英伟达也当仁不让地被推向了“算力霸主”的王座。今年以来,其股价已上涨160%,市值一度突破万亿美元,相当于四个AMD、七个英特尔。

然而,作为AI的基础设施,算力芯片环节的“一家独大”显然不是有利于行业长远发展的生态。因此,市场不免将更多的期待寄托于GPU“二号玩家”AMD身上,而AMD也早早将目标瞄向英伟达的AI王座。AMD究竟有几分胜算?想窥得这个问题的答案,让我们将目光移向它的发布会上一探究竟。

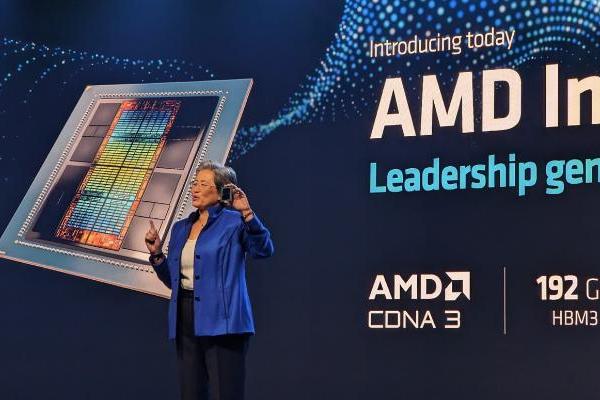

当地时间12月6日消息,AMD在美国圣何塞举办的“Advancing AI”活动中宣布,将推出全新的AI芯片系列Instinct MI300,包括MI300A和MI300X等型号,以及相应的软件和服务。MI300A已经开始量产,而MI300X则已经开始发货。英伟达在AI这一新兴市场的主导地位或将受到严重挑战!

MI 300X芯片是适用于各种各样生成式AI应用场景的芯片;MI 300A则更适用于用在HPC 应用和数据中心上。

在硬件参数配置上,两颗芯片有共性也有差异。

MI300A 与 MI300X 采用相同的基本设计和方法,两颗芯片都采用采用了一种名为“3.5D封装“的技术来生产,并且也都是基于 AMD第四代的Infinity架构打造。

在内存方面,两颗芯片都采用了现下大热的HBM 3设计,但是MI 300A用的是 128GB的 HBM 3设计,MI 300X 用的是内存更大的 192GB HBM 3设计;

在计算单元方面,MI 300X 搭载了304个CDNA 3 计算单元,每个计算单元中还有34个计算单位。而MI 300A的计算单元更少,只有228个。

在发布会上,AMD几乎全程硬刚英伟达,MI300x 全程“拉踩”H100。

据AMD称,在最常见的大型语言模型内核的性能方面,MI300X比H100略快。

但是,尽管AMD表示,该芯片为大型语言模型提供了相同的训练性能,但与竞争对手相比,其改进的内存能力将节省大量成本。

““这是世界上性能最高的生成式人工智能加速器,”AMD首席执行官苏姿丰在演讲中谈到MI300X时说。

Instinct MI300X 基于 CDNA 3 架构,这是 AMD 的第三代 GPU 架构,专为数据中心的 AI 和 HPC 工作负载而构建。

但是,尽管AMD在MI300A的HPC和AI融合中更加重视工作负载,但该公司认为MI300X在大型语言模型(如Meta的开源Llama 2系列)上训练和运行推理方面将具有更大的吸引力。

它配备了 192GB 的 HBM3 高带宽内存,是 2022 年英伟达 H100 SXM GPU 的 80GB HBM3 容量的 2.4 倍。它也高于英伟达最近宣布的H200的141GB HBM3e容量,后者将于明年第二季度上市。虽然 MI300X 参数上不如英伟达最新产品 H200,但由于 H200 的出货时间比较晚,因此 MI300X 仍被认为是对当前算力市场的有力补充。

MI300X 的内存带宽为 5.3 TB/s,比 H100 的 3.3 TB/s 容量高出 60%,也比 H100 的 4.8 TB/s 容量高。

但是,虽然 H100 的 SXM 外形尺寸需要 700 瓦的功率,但 MI300X 的要求略高,功率范围为 750 瓦。

在HPC性能方面,AMD表示,MI300X可以通过双精度浮点数学(也称为FP64)实现高达163.4 teraflops的矩阵运算。对于 FP64 矢量运算,芯片可以达到 81.7 teraflops。这些数字比 英伟达 的 H100 增加了 2.4。

对于单精度浮点数学(也称为 FP32),MI300X 的矩阵和矢量运算都可以达到 163.4 teraflops。据AMD称,该芯片的矢量性能是H100所能达到的2.4倍。它补充说,H100 无法进行 FP32 张量运算,因此矩阵运算没有可比性。

至于关键的人工智能性能指标,AMD表示,MI300X比H100快30%,用于TensorFloat-32或TF32(653.7 teraflops)、半精度浮点或FP16(1307.4 teraflops)、大脑浮点或BFLOAT16(1307.4 teraflops)、8位浮点或FP8(2614.9 teraflops)和8位整数或INT8(2614.9 teraflops)。

据AMD称,在最常见的大型语言模型内核的性能方面,MI300X比H100略快。

对于 Meta 的 700 亿参数 Llama 2 模型的内核,MI300x 的中型内核快 20%,大内核快 10%。对于 Flash Attention 2,MI300X 在中型内核上快 10%,在大内核上快 20%。

““这意味着内核级别的性能实际上直接转化为更快的结果,”苏姿丰说。

AMD 没有透露新品的定价,但 CEO 苏姿丰声称比市场上的其它产品有更高的性价比,目前已向众多 OEM 合作伙伴发货。

微软首席技术官 Kevin Scott 作为发布会的演讲嘉宾宣布,MI300X 已经部署到 Azure 当中,Azure ND MI300X 虚拟机现已推出预览版。 Meta 还宣布将在其数据中心部署 MI300 处理器。另外,惠普、戴尔、联想等数家数据中心基础设施提供商,也宣布将计划在其产品集成MI300。

此前,AMD 预计 AI 芯片将在新财季带来 4 亿美元增收,收入在明年将超过 20 亿美元。作为对比,英伟达的数据中心硬件在最新财季的收入为 145 亿美元,高于去年同期的 38 亿美元。

在发布会上,AMD董事长苏姿丰表示,预计到2027年,用于数据中心的人工智能芯片的整体市场规模将达到4000亿美元,年复合增长率将达到 70%。

在AI这一新兴领域中,英伟达已占得先机。而AMD不甘示弱,手握着其“终极武器”,势必要在算力芯片领域掀起一场“腥风血雨”,究竟能否打败英伟达,登上AI“王座”?让我们拭目以待。

- END -

最新活动更多

-

3月27日立即报名>> 【工程师系列】汽车电子技术在线大会

-

4月1日立即下载>> 【村田汽车】汽车E/E架构革新中,新智能座舱挑战的解决方案

-

即日-4.22立即报名>> 【在线会议】汽车腐蚀及防护的多物理场仿真

-

4月23日立即报名>> 【在线会议】研华嵌入式核心优势,以Edge AI驱动机器视觉升级

-

4月25日立即报名>> 【线下论坛】新唐科技2025新品发布会

-

5月15日立即下载>> 【白皮书】精确和高效地表征3000V/20A功率器件应用指南

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论