自动驾驶应该像人一样思考还是感知?

文︱立厷

图︱网络

人们希望自动驾驶汽车能够像人一样思考,或像机器人一样思考,因为计算机的能力比人脑更强;同时还希望像人一样感知,进而能够像人一样开车。要求有点高了,真能做到,自动驾驶也不会是今天的样子。

早在2019年,特斯拉就在“自动驾驶投资者日”上说,通过观测人类驾驶员在各种路况所选择的路径和典型人类行动,来创建带有人类标记的图像来训练网络。特斯拉希望利用感知系统超越环境模仿人类大脑智能感知能力,利用人工智能(AI)让自动驾驶汽车像机器人一样思考,就像人类数以百万计的神经元组成的神经网络那样。

结果呢?直到2021年,对大货车视而不见车毁人亡的场面还是屡见不鲜,且不仅是特斯拉。

另一种声音是,像人一样思考,不如像人一样感知,而且有了这样的感知技术。

人脑的启示

三十多年来,斯坦福大学医学院神经外科系的临床教授和医学博士James Doty一直在研究和实施人脑手术。“我一直着迷于大脑的力量、可塑性和适应性,以及它惊人的能力中有多少用于处理和解释我们从感官接收到的数据。”他说。

Doty还是斯坦福大学同情和利他主义研究与教育中心的创始人和主任。他与来自多个学科的科学家合作,研究人的神经基础。他拥有多项专利,曾是射波刀技术的发明者Accuray的前首席执行官;也是《走进魔法商店:神经外科医生探索大脑奥秘和心脏奥秘》的纽约时报畅销书作者。

他认为,自动驾驶汽车的未来是像机器人一样思考,更要像人一样感知。

他指出,随着AI的迅速崛起,开发人员需要整合复杂、多层次的人类感知来增强AI能力。问题在于,这种集成的应用如何满足整个自主统一体的要求,包括从ADAS到移动性,以及卡车运输、交通、建筑、铁路、智能交通系统(ITS)、航空航天和国防领域的自动化应用。

“很明显,对我来说,驱动这些应用所需的AI需要模仿地球上最伟大的感知引擎——人类视觉皮层。这些交通工具需要像机器人一样思考,但先要像人一样感知。”

为了了解更多信息,更好地理解这种人工感知水平如何产生,他成为了AEye的顾问。AEye是一家开发尖端人工感知和自动驾驶技术的公司,帮助他们利用人脑知识更好地为系统提供信息。这就是仿生:从生物系统(植物、动物、人类等)学习和复制自然策略,以创造更灵敏、更智能的技术和产品。从本质上说,仿生学使人们能够适应现有环境,并以数十亿年来生命成功的方式进化。

为什么将仿生学和人类感知的各个方面纳入自动驾驶汽车的开发之中呢?

Doty解释说,因为没有什么能比人类的视觉皮层接收更多的信息并更快、更准确地处理。人类以高达27Hz的速度对复杂物体进行分类,大脑在13毫秒内处理5.8亿像素数据。他告诫说:“如果我们继续使用传统的传感器数据收集方法,我们距离自动驾驶车辆中AI实现人脑功能还有25年多的时间。因此,为了使自动驾驶汽车能够在拥挤的城市环境中或以高速公路速度安全地独立行驶,我们必须开发新的方法和技术,以达到或超过人脑的性能。”

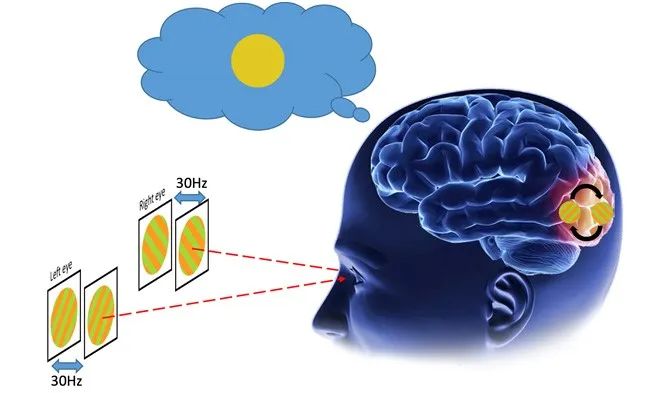

2016年科学家发现,解决视觉冲突需要关注而并不需要意识相关机制的参与

人脑像现在的自动驾驶,人类早就灭绝了

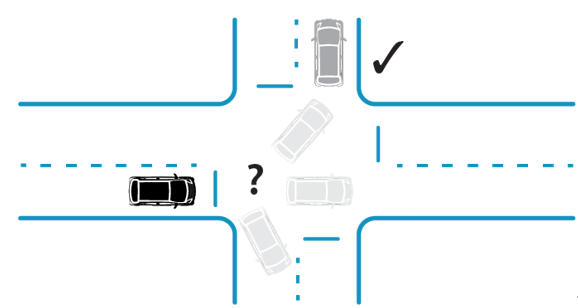

下一个问题是:如何做?并非所有物体都生来一样,人能够看到一切,却只关注重要的事情。人类不断地分析所处的环境,不断“扫描”新的物体,然后并行地(并视情况而定)关注有趣或潜在威胁的元素。人的视觉皮层处理速度非常快,准确度令人难以置信,几乎不用大脑巨大的处理能力。“如果人类的大脑像今天的自动驾驶汽车一样工作,我们就不会作为一个物种存活下来。”Doty说。

Bob Nease在《决策的力量》(The Power of Five Bits)一书中描述人类大脑每秒处理一千兆比特(bit)信息,但只有50比特用于有意识思维。这是由多种进化因素造成的,包括我们对忽略心脏跳动等自主过程的适应,或者由视觉皮层筛选出与生存无关的环境信息。

这就是我们智慧愿景的本质。虽然我们的眼睛总是在扫描和搜索,以识别进入场景的新对象,但我们将注意力集中在重要对象上,因为它们移动到受关注的区域,使我们能够做出适当的响应。简言之,我们搜索场景,有意识地获取重要对象,并根据需要对其采取行动。

当前的自主车辆传感器配置利用激光雷达、摄像头、超声波和雷达的组合作为其“感官”,限于固定搜索模式连续(单向)收集信息。这些“感官”收集尽可能多的数据,然后在事件发生很久之后进行校准、处理和分析。这种后处理速度很慢,无法实现实时捕获感官数据方式的变化。因为这些传感器不会智能地发出询问,所以收集到的90%感官数据在处理时会被丢弃,因为这些数据要么无关,要么冗余。这种分类行为也会带来延迟惩罚。在高速公路速度,这种延迟会导致车辆在传感器数据完全处理之前移动超过6米。为了提高效率而丢弃不需要的数据效率很低。

对每棵树、路缘、停放的车辆、道路和其他静态对象进行数据筛选的艰巨任务也需要巨大的电力和数据处理资源(算力),虽然功率随算力不断攀升,整个系统的速度并没有多大起色,并带来了风险。这些系统的目标是关注一切,然后在事后尝试分析环境中的每一项,而牺牲及时的行动。这与人类在与驾驶相关的情况下处理时空数据的方式完全相反。

人是直觉学习动物

如前所述,人类视觉皮层的扫描频率为27Hz,而自动驾驶传感器平均为10Hz左右。大脑自然地从视觉皮层收集信息,形成反馈回路,帮助提高感知过程每一步的效率。然后,大脑引导眼睛搜索并聚焦于某些物体,识别它们并确定其优先级,并决定最有效的行动方案,同时在很大程度上忽略其他不太重要的物体。这种优先顺序允许更高的效率并增加时间和空间采样,不仅扫描更智能,而且效果更好。

你试试看,环顾四周,发现有许多深度、颜色、阴影和其他信息需要用眼睛捕捉,然后是运动。再考虑一下你的经验:某个物体能够运动还是可能保持静止?它的行为是可预测还是不稳定的?你觉得这个物体有价值吗?还是认为它没什么用?虽然你没有意识到这些结果,但大脑是这样做的。

自动或半自动车辆当前的传感器系统针对“搜索”进行了优化,然后将“搜索”报告给中央处理器。搜索是通过单个被动传感器完成的,无论环境如何变化,这些传感器在任何时候都会在任何地方使用相同功率、强度和搜索模式。

局限性在于:数据只从被动传感器单向流向中央处理器,无法主动适应或调整其采集。所有智能都是在融合和毁灭之后添加的,当实时学习和调整为时已晚时,高达95%的智能会被丢弃。

智能探测和感知

Blair LaCorte是AEye首席执行官,也是积极训练同盟(Positive Coaching Alliance)董事会成员,曾荣获美国宇航局颁发的“年度创新者”和《行业周刊》的“年度产品”奖。

在他的公司,智能激光雷达传感器系统iDAR?(智能探测和测距)是一种创新的高性能固态主动激光雷达,使自动驾驶车辆能够像人类一样“搜索、获取和行动”。它通过定义新的数据和传感器类型来实现这一点,这些数据和传感器类型可以更有效地传达可操作的信息,同时具有快速准确地分析这些数据的智能。

LaCorte介绍说,iDAR平台分为四个简单层次,每层都是为了满足各种出行要求,如ADAS、交通运输、建筑、铁路、ITS、航空航天等领域特定用例或应用。四个层次是:设计性iDAR、触发性iDAR、响应性iDAR和预测性iDAR。

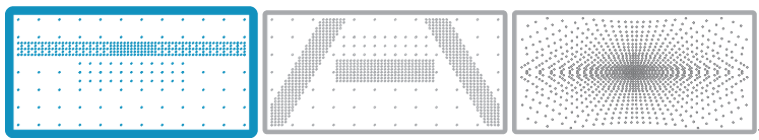

设计性iDAR:允许创建单一的确定性扫描模式,为特殊用例提供最佳信息;

设计性iDAR

触发性iDAR:通过外部输入(如地图、速度和天气)触发确定性模式库;

触发性iDAR

响应性iDAR:能够感知场景,实时调整场景扫描方式,使用不同密度和额外功率。

响应性iDAR

响应iDAR平台由反馈回路和其他传感器(如摄像头和雷达)通知激光雷达聚焦于特定兴趣点。系统智能化能够主动理解和询问场景,并不断优化自身扫描模式和数据收集,以关注最重要的信息,类似于人类感知。

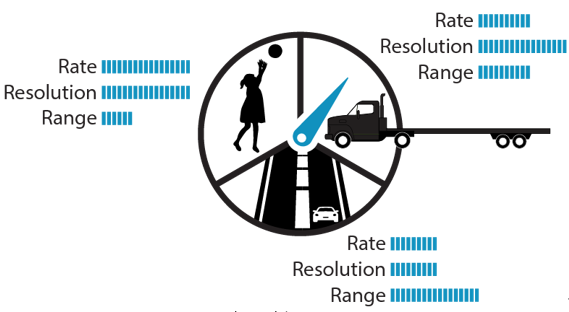

因此,与标准激光雷达不同,AEye的主动激光雷达具有情境适应性,可以修改扫描模式和资源,如功率、更新率、分辨率、重现和范围。这使得iDAR能够动态利用传感器资源,以最佳方式搜索场景,有效识别和获取关键对象,例如道路上的儿童或进入十字路口的汽车,并确定适当的行动方案。实时执行此操作对安全出行、避免悲剧至关重要。

iDAR被认为是唯一一个用于ADAS、移动性等的人工感知平台,它是真正的软件可配置的,能够实现智能和主动感知。通过使用主动激光雷达在传感器级别根据客户或应用自定义数据收集,并提供大量可调整和自定义的配置设置,智能收集数据,以满足自主应用需求。iDAR可以适应新的技术和算法,不断优化成本和性能。

像人类一样动态感知

iDAR是一个活跃的多维系统,它依靠反馈回路高效地循环信息,以适当地实时修改反应,就像人类一样。摄像头可以与激光雷达通信,同时传感器系统可以与路径规划系统实时通信。

除了提高响应时间,反馈回路还使人工智能能够更有效地与人工感知相结合。现在的传感器系统无论在什么情况下都会被动地反馈相同类型的数据。iDAR将感官数据捕获和处理推送到传感器,而不是集中处理器,支持更快的集成反馈循环来通知和排队操作。通过这种方式,iDAR系统能够持续学习,以便随时间推移更有效地识别和跟踪可能威胁自动驾驶车辆、乘客、其他驾驶员和行人安全的对象和情况。

这就是前面所说的预测性iDAR。像人类一样,它能够理解所看到的一切运动,这使得系统能够用更少的数据传递更多的信息,将其能量集中在场景中最重要的对象,同时关注周围的一切。其最终结果是通过神经网络进行运动预测。与人类的直觉一样,可以“感知”(预测)未来不同时间物体的位置,帮助车辆评估碰撞风险并确定安全路线。

预测性iDAR

当涉及到运动物体感知时,通常需要两种类型的关键正交数据集:空间和时间。空间数据确定对象在世界上的位置,而时间数据确定对象在时间上的位置。通过将这些数据集与其他数据集(如颜色、温度、声音和气味)集成在一起,我们的大脑就可以生成周围世界的实时模型,定义我们的体验方式。

人类大脑自然地接收各种正交数据,在我们没有意识到的情况下,即时分离和重组信息。例如,如果你看到一个棒球向你飞来,你的大脑就会收集关于它的各种信息,比如空间(球的方向)和时间(球移动的速度)。当你的视觉皮层在“背景”中处理这些数据时,你最终意识到的是你需要采取的行动,可能是躲避。

LaCorte认为,能够成功采用人脑捕获和处理这些类型数据集的方式的AI感知技术将主宰市场。而现有的机器人传感器系统只专注于单传感器模式(摄像头、激光雷达或雷达),且只具有固定的扫描模式和强度。与人类不同,这些系统没有当传感器检测到物体运动时实时有效地处理和优化2D和3D数据的学习能力。简单地说,它们不能使用实时正交数据来学习、排序和聚焦。因此,有效地复制人类视觉皮层的多维感官处理能力需要一种新的方法来思考如何捕获和处理感官数据。

所谓正交数据指的是互补数据集,最终为我们提供有关某个对象或情况,比单独提供的质量信息更多。这使我们能够确定所处世界中什么是重要的,什么不是。高信息质量的正交性概念已被很好地理解,并植根于量子物理等学科,在这些学科中,使用线性代数,用正交基集(basis set)表示更复杂状态而不需要冗余的最小信息片段。

AEye的智能感应方法能够捕捉“多种感官”,并对车辆周围环境有更广泛的了解。通过固态主动激光雷达与高分辨率摄像头的物理融合,AEye创建了一种称为动态Vixel(体素)的新数据类型,该数据类型可捕获摄像头像素和3D激光雷达体素。捕获RGB和XYZ数据使车辆能够像人类一样(如果不比人类更好的话)实现可视化。颜色不仅主导着驾驶基础设施(如标志或交通灯),也是视觉皮层的主要驱动因素之一。创造出动态体素就可以仿生人类视觉皮层的数据结构。

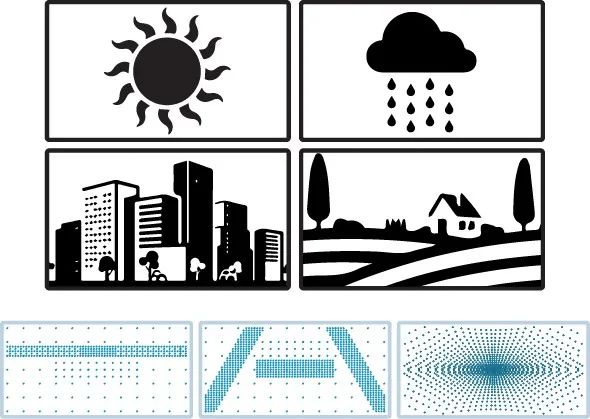

与人类视觉皮层一样,动态体素中固有的智能随后被整合到中央感知引擎和运动规划系统(即车辆的功能大脑)中。它们是动态的,因为它们能够根据不断变化的条件进行调整,例如增加传感器的功率水平以穿透雨水,或者在同一帧中重新检查可疑物体以识别障碍物。更好的数据驱动可以获得更多可操作的信息。

需要超乎想象

如果像机器人一样思考,像人类一样感知,就可以从逻辑上减少人类的弱点,如攻击性行为、疲劳、分心或酗酒风险;有可能达到并超越人类视觉皮层和大脑的能力,实现有史以来最强大的感知引擎。这样我们就将节省时间、金钱、减轻压力并提高安全性。

仿生学告诉我们,对于自动驾驶车辆,人工感知应该在传感器上进行更多的处理,以便有效地发挥作用。据称,AEye的iDAR传感器系统是唯一能够成功处理行业最具挑战性极端情况的传感器,同时实现了超过200Hz(6倍人类视觉)的扫描速度,探测范围为1公里(当前激光雷达的3-5倍),而这已经VSI Labs测试:在超过1000米距离能够检测到目标更多的点数。

图片新闻

分享

分享

发表评论

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论