ECCV2020 GigaVision挑战赛,深兰科技包揽十亿级像素双赛道冠军

赛道二 Multi-Pedestrian Tracking

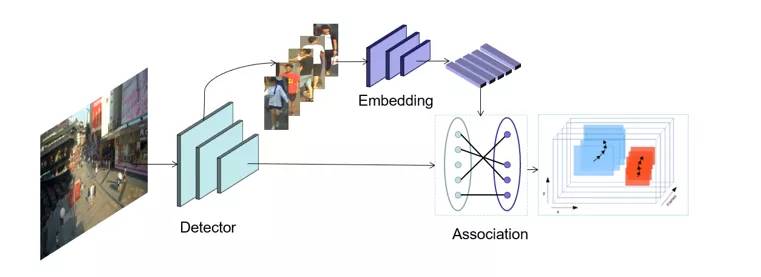

赛题分析 多行人跟踪问题是一个典型的多目标跟踪问题。通过调研总结发现,Tracking-by-detection是处理这一问题的常用且精度比较高的方法[2][7]。

基本的流程可以总结如下:

1)在每一帧中检测物体的位置。2)为每个检测框提取特征。3)通过将特征距离或空间距离将预测的目标与现有轨迹关联。

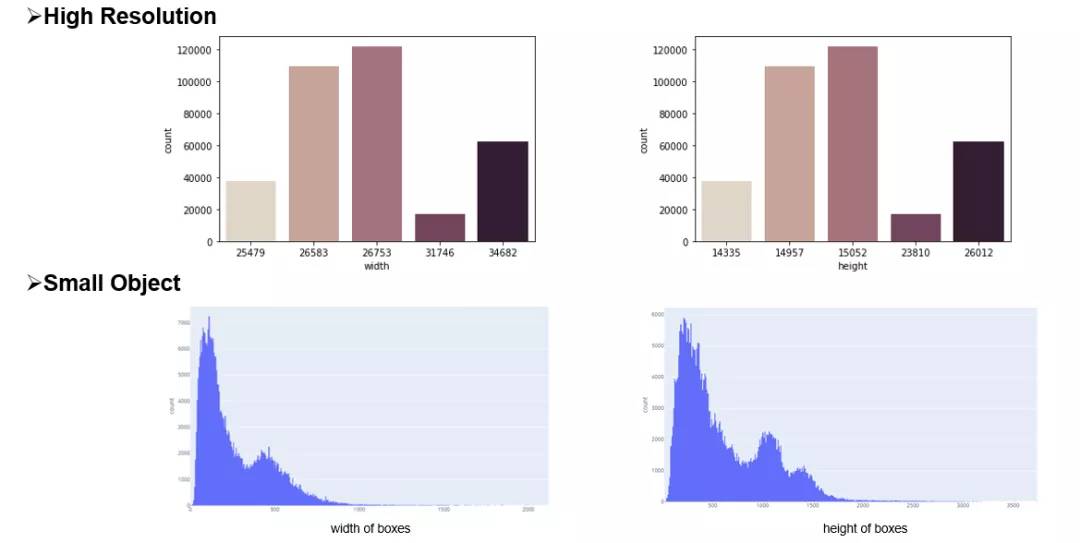

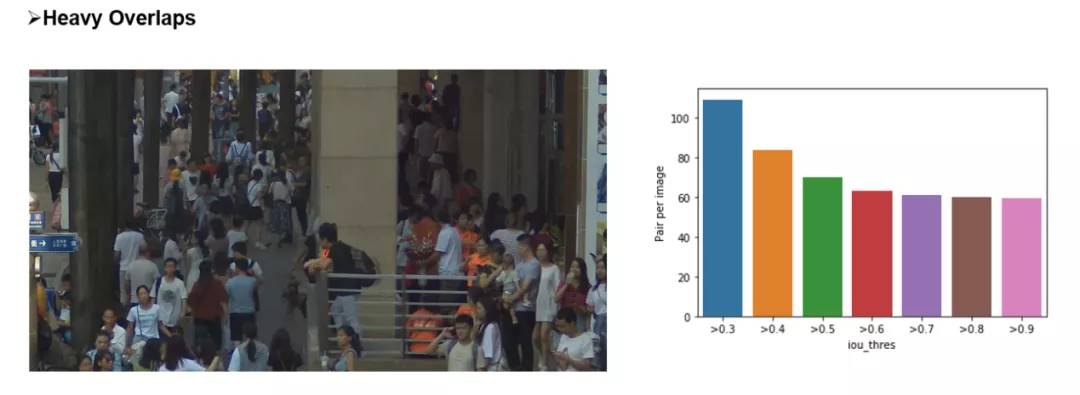

本次挑战赛更注重精度,因此采用了分离Detection和Embedding的方法,该方法的模块化设计的优点使得竞赛精度上优化空间的十分大。通过简单的数据统计分析和可视化分析,团队认为该比赛的主要挑战在于图像的大分辨率和行人的严重拥挤,如下图所示。

为了应对这些挑战,针对高分辨、小目标等问题,引入了一种滑动窗口检测算法。针对遮挡严重的问题,使用局部和全局特征来衡量两个相邻帧之间的预测边界框的相似距离,并且借鉴了FairMOT的特征平滑的方法进行缓解。

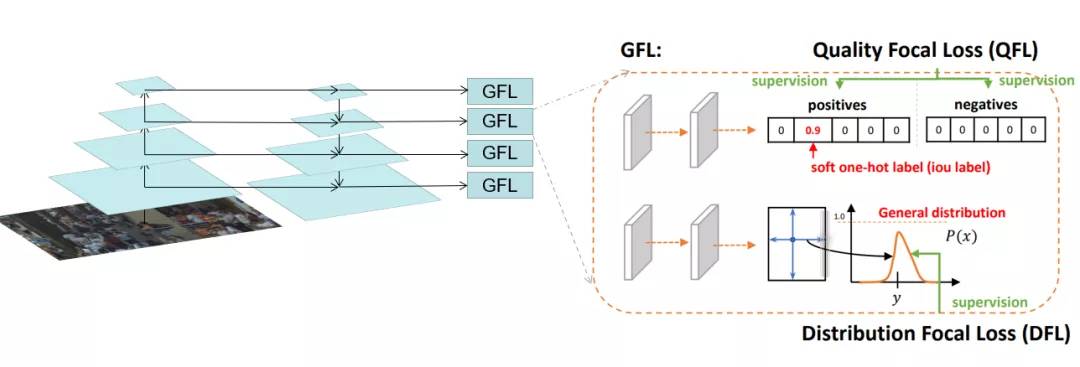

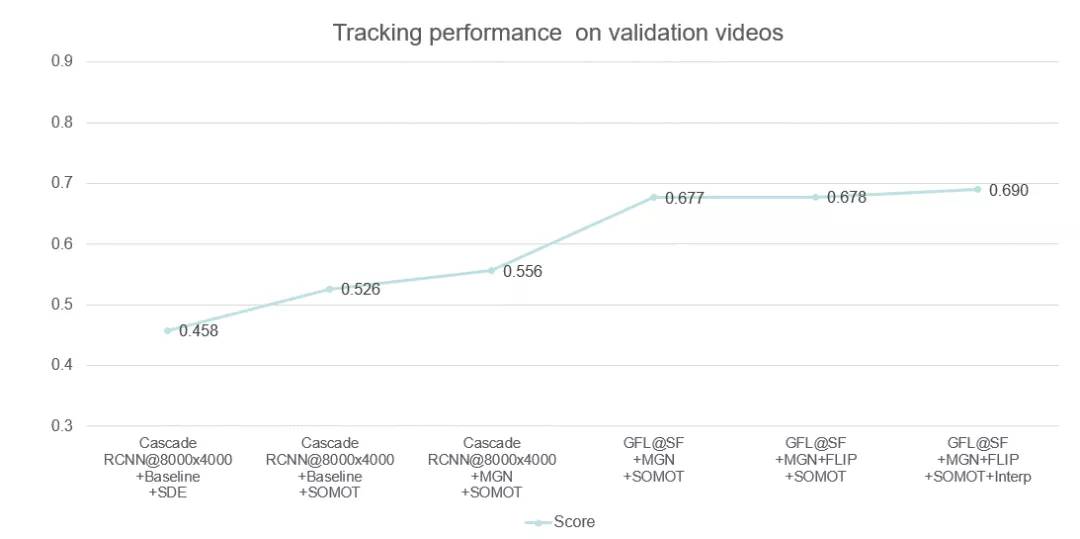

竞赛方案: 本次采用的多目标跟踪系统是基于Detection和Embedding分离的方法,采用了以Generalized Focal Loss(GFL)[9]为损失的anchor-free检测器,并以Multiple Granularity Network (MGN)[10]作为Embedding模型。

在关联过程中,借鉴了DeepSORT[6]和FairMOT[8]的思想,构建了一个简单的在线多目标跟踪器, 如下图所示。

检测器

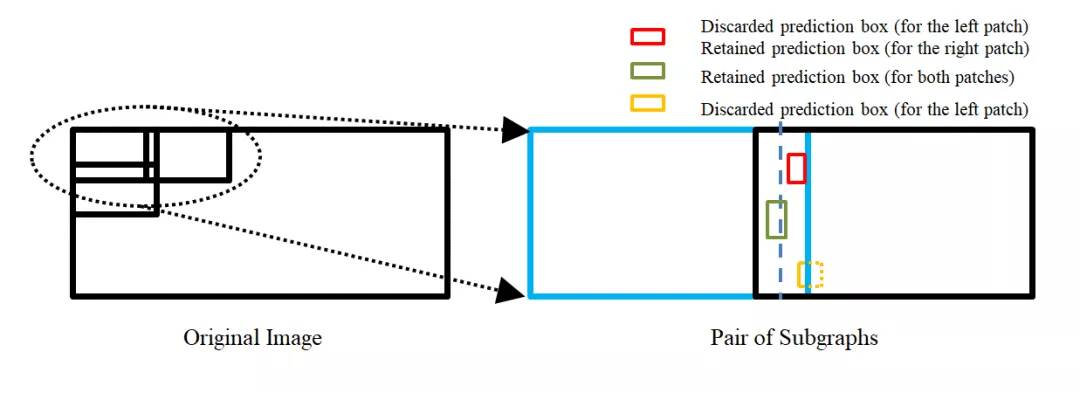

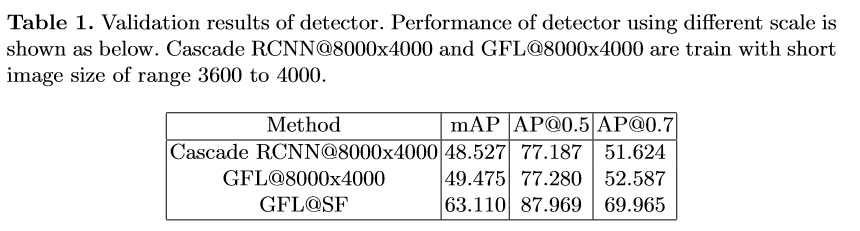

检测部分: 为了处理高分辨率的图像,我们提出了一个segmentation-and-fusion(SF)的方法,如下图所示。每一张大图有交叠的切分成多个子图,每一个子图的分辨率为6000*6000,位于图像边缘的子图直接填充均值。为了防止较大的行人目标被切分成进两个子图,相邻的子图横向上重叠宽度为1000像素,纵向重叠宽度设置为2000像素。在融合子图检测结果时,我们采用一种基于子图重叠中线和检测框相交判定的规则。比如,对于一对横向有重叠的子图,如果基于左子图的检测框处于子图重叠中线的右侧,但与该中线相交,该检测框就被保留,反之则丢弃该检测框。通过segmentation-and-fusion方法,与直接合并进行NMS的方法相比, 我们在本地检测验证集取得了0.2AP的提升。

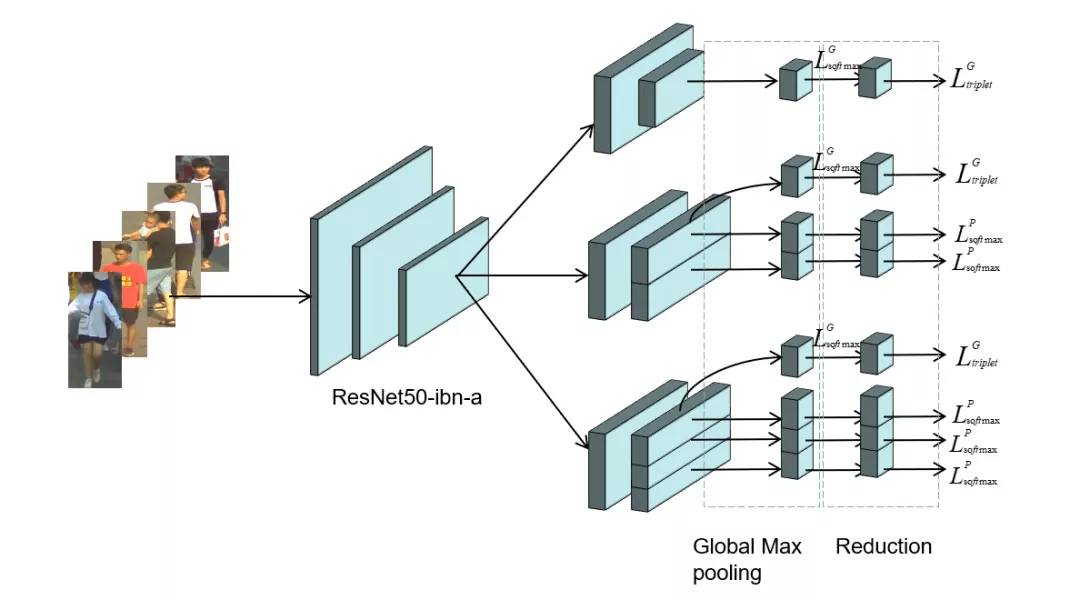

Embedding部分:

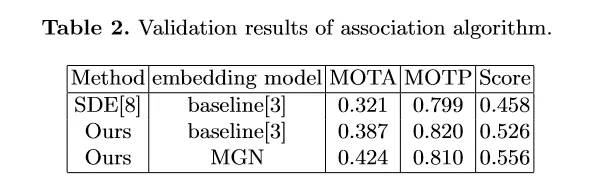

为了解决行人拥挤带来的问题,我们采用了Multiple Granularity Network(MGN),如上图所示。我们首先利用Resnet50-ibn-a[4]提取特征,然后使用Triplet loss和Softmax loss计算三个全局特征的损失,仅使用Softmax loss计算局部特征的损失。此外,我们使用了ReID中的常用的训练技巧来优化MGN的性能[3]。 Data Association: 我们借鉴了DeepSORT和FairMOT的想法,以检测框的表观距离为主,以检测框的空间距离为辅。首先,我们根据第一帧中的检测框初始化多个轨迹。在随后的帧中,我们根据embedding features之间的距离(最大距离限制为0.7),来将检测框和已有的轨迹做关联。与FairMOT一致,每一帧都会通过指数加权平均更新跟踪器的特征,以应对特征变化的问题。对于未匹配的激活轨迹和检测框通过他们的IOU距离关联起来(阈值为0.8)。最后,对于失活但未完全跟丢的轨迹和检测框也是由它们的IoU距离关联的(阈值为0.8)。

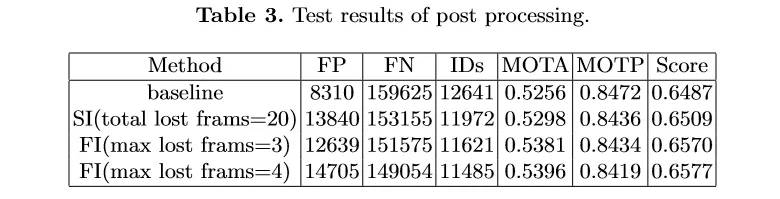

后处理: 由于只对较高的置信度的检测框进行跟踪,因此存在大量假阴性的检测框,导致MOTA[1]性能低下。为了减少置信阈值的影响,团队尝试了两种简单的插值方法。

1) 对总丢失帧不超过20的轨迹进行线性插值。我们称之为简单插值(simple interpolation, SI);

2)对每一个轨迹只在丢失不超过4帧的帧之间插入。另外,我们称之为片段插值(fragment interpolation, FI)。

虽然插值的方法增加了假阳性样本的数量,但是大大减少了假阴性样本,使我们在测试集上实现了0.9左右的提升。不同插值方法的效果如下表所示。

以上是团队对参赛方案的优化路线图,通过优化检测器以及特征提取器,数据关联方法、后处理等方法,在GigaVision 2020多行人跟踪挑战赛中获得第一名的成绩。

总结与思考

本文针对GigaVision多行人跟踪挑战赛,设计了一个简单、在线的多目标跟踪系统,包括检测器、特征提取、数据关联和轨迹后处理,在GigaVision 2020多行人跟踪挑战赛中获得第一名。很荣幸取得这次竞赛的第一名,在这里也分享一下针对多目标跟踪任务的一些问题以及思考: 1)检测器和特征提取器mAP越高,最终跟踪的性能也会相应的提升?2)数据关联过程真的需要运动模型么?3)跟踪器的特征平滑为何有效?4)Part-Based的特征提取器为何有效?

团队对以上问题进行了思考,得出一些比较简单的看法: 1) 一般来说检测器和特征提取器的性能越理想,最终跟踪的性能也会有相应的提升;mAP作为常用的检测器评估指标来说,mAP的提升不一定能带来跟踪的性能提升,当然这也和评价指标有关系,需要具体问题具体分析,比如检测上多尺度增强带来的AP增益往往会造成MOTA的降低。 mAP作为特征提取器的评估指标来说,mAP的提升也不一定能带来跟踪的性能提升,比如Part-Based 的MGN在本次竞赛中虽然mAP比全局特征提取器差几个点,在最后的跟踪上却取得不错的效果。2)现实中的多目标跟踪任务中,摄像头的突然运动以及跟踪对象的突然加速往往都是存在的,这时候的运动模型其实动态性能十分的差劲,反而造成不好的跟踪效果,本次竞赛采用的是直接不采用运动模型的方法。3) 跟踪器的特征平滑操作十分简单有效,不需要类似于DeepSORT进行级联匹配,速度比较快,考虑了同一轨迹的历史特征,使得特征更加鲁棒,减少了单帧跟踪错误带来的影响; 4) Part-Based的特征提取器针对这种遮挡比较严重的情况在距离度量时考虑了各个部分的特征,特别的,遮挡部分往往变化比较大,结合特征平滑操作,一定程度上消除了遮挡部分的影响,更关注没有遮挡部分的特征。

参考文献:

1.Bernardin,K.Stiefelhagen,R.:Evaluatingmultipleobjecttrackingperformance(2008)

2.Milan,A.,Leal-Taixe,L.,Reid,I.,Roth,S.,Schindler,K.:Mot16:Abenchmarkformulti-objecttracking(2016)

3.Luo,H.,Gu,Y.,Liao,X.,Lai,S.,Jiang,W.:Bagoftricksandastrongbaselinefordeeppersonre-identification(2019)

4.Pan,X.,Luo,P.,Shi,J.,Tang,X.:Twoatonce:Enhancinglearningandgeneralizationcapacitiesviaibn-net(2018)

5.Wang,X.,Zhang,X.,Zhu,Y.,Guo,Y.,Yuan,X.,Xiang,L.,Wang,Z.,Ding,G.,Brady,D.J.,Dai,Q.,Fang,L.:Panda:Agigapixel-levelhuman-centricvideodataset(2020)

6.Wojke,N.,Bewley,A.,Paulus,D.:Simpleonlineandrealtimetrackingwithadeepassociationmetric(2017)

7.Yu,F.,Li,W.,Li,Q.,Liu,Y.,Shi,X.,Yan,J.:Poi:Multipleobjecttrackingwithhighperformancedetectionandappearancefeature(2016)

8.Zhang,Y.,Wang,C.,Wang,X.,Zeng,W.,Liu,W.:Asimplebaselineformulti-objecttracking(2020)

9.Li,X.,Wang,W.,Wu,L.,Chen,S.,Hu,X.,Li,J.,Tang,J.,Yang,J.:Generalizedfocalloss:Learningqualifiedanddistributedboundingboxesfordenseobjectdetection.arXiv(2020)

10.Wang,G.,Yuan,Y.,Chen,X.,Li,J.,Zhou,X.:Learningdiscriminativefeatureswithmultiplegranularitiesforpersonre-identification.CoRRabs/1804.01438(2018)

11.Cai,Z.,Vasconcelos,N.:Cascader-cnn:Delvingintohighqualityobjectdetection.In:ProceedingsoftheIEEEconferenceoncomputervisionandpatternrecognition.pp.6154–6162(2018)

12.Cao,Y.,Xu,J.,Lin,S.,Wei,F.,Hu,H.:Gcnet:Non-localnetworksmeetsqueeze-excitationnetworksandbeyond.In:ProceedingsoftheIEEEInternationalConferenceonComputerVisionWorkshops.pp.0–0(2019)

13.Dai,J.,Qi,H.,Xiong,Y.,Li,Y.,Zhang,G.,Hu,H.,Wei,Y.:Deformableconvolutionalnetworks.In:ProceedingsoftheIEEEinternationalconferenceoncomputervision.pp.764–773(2017)

14.Hu,J.,Shen,L.,Sun,G.:Squeeze-and-excitationnetworks.In:ProceedingsoftheIEEEconferenceoncomputervisionandpatternrecognition.pp.7132–7141(2018)

15.Li,X.,Wang,W.,Wu,L.,Chen,S.,Hu,X.,Li,J.,Tang,J.,Yang,J.:Generalizedfocalloss:Learningqualifiedanddistributedboundingboxesfordenseobjectdetection.arXivpreprintarXiv:2006.04388(2020)

16.Solovyev,R.,Wang,W.:Weightedboxesfusion:ensemblingboxesforobjectdetectionmodels.arXivpreprintarXiv:1910.13302(2019)

最新活动更多

-

7.30-8.1火热报名中>> 全数会2025(第六届)机器人及智能工厂展

-

7月31日免费预约>> OFweek 2025 具身机器人动力电池技术应用大会

-

免费参会立即报名>> 7月30日- 8月1日 2025全数会工业芯片与传感仪表展

-

即日-2025.8.1立即下载>> 《2024智能制造产业高端化、智能化、绿色化发展蓝皮书》

-

8月5日立即报名>> 【在线会议】CAE优化设计:医疗器械设计的应用案例与方案解析

-

8月14日立即报名>> 【在线研讨会】解析安森美(onsemi)高精度与超低功耗CGM系统解决方案

分享

分享

发表评论

登录

手机

验证码

手机/邮箱/用户名

密码

立即登录即可访问所有OFweek服务

还不是会员?免费注册

忘记密码其他方式

请输入评论内容...

请输入评论/评论长度6~500个字

暂无评论

暂无评论